Elon Musk anunció hoy que Tesla permitirá a sus propietarios de vehículos eléctricos con conducción totalmente autónoma (FSD) (supervisada) “despachar mensajes de texto y conducir” en “uno o dos meses”, sin explicar cómo sortearán las leyes claras que lo prohíben.

Hace al punto que unos meses, Musk volvió a afirmar que Tesla finalmente entregaría su tan prometida “conducción autónoma sin supervisión” a los vehículos de consumo para fin de año, poco que ha hecho todos los primaveras durante los últimos 6 primaveras y nunca ha cumplido.

Faltan menos de 2 meses para el postrero cronograma.

En la reunión de accionistas de Tesla de hoy, Musk actualizó su cronograma, diciendo ahora que Tesla está a “unos meses” de FSD no supervisado, lo que podría llevarlo hasta 2026.

Incluso añadió que Tesla está “casi” registro para permitir “despachar mensajes de texto y conducir” con FSD y dijo que dilación que Tesla lo habilite en el interior de “uno o dos meses”.

Sin bloqueo, el CEO no dio más detalles sobre cómo planea Tesla lograrlo.

Destinar mensajes de texto y conducir es ilegal en la mayoría de las jurisdicciones, incluido Estados Unidos. Existen importantes multas y sanciones legales si se lo descubre. Para “permitir eso”, Tesla necesitaría encargarse la responsabilidad de los vehículos de consumo cuando se conduce FSD, lo que significaría la “conducción autónoma sin supervisión” prometida anteriormente o la conducción autónoma de niveles 3 a 5 de SAE.

Hay varios pasos legales y regulatorios que Tesla debe tomar para que esto suceda y, hasta ahora, no hay evidencia de que el fabricante de automóviles se haya embarcado en ese delirio.

Hasta ahora, Tesla se ha escaso a proyectos piloto con flotas internas para ofrecer servicios de transporte con supervisores a borde cuando las regulaciones lo permitan.

Musk dijo que Tesla “mirará los datos” ayer de permitir despachar mensajes de texto y conducir.

Es sabido que Tesla nunca ha publicado datos relevantes sobre la seguridad de sus funciones de conducción autónoma.

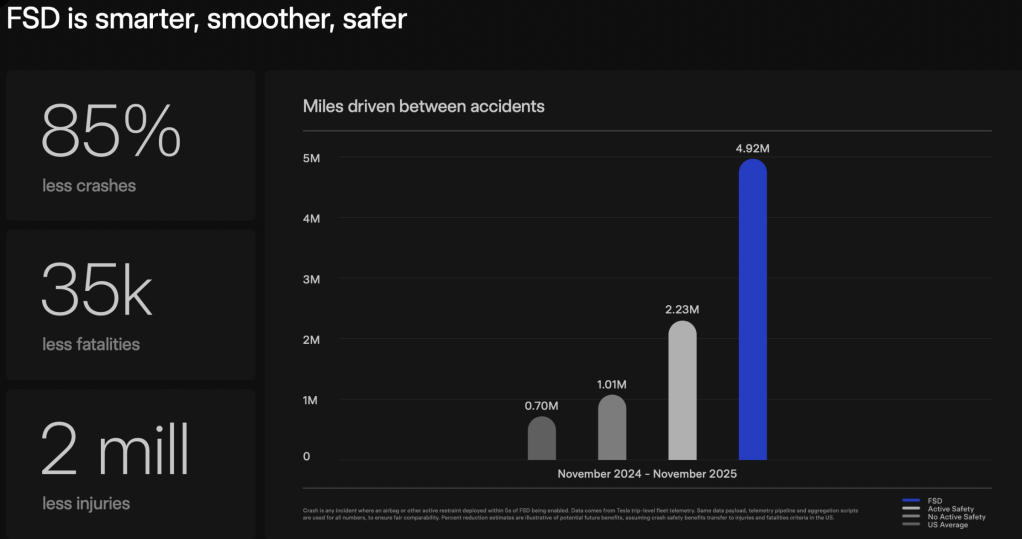

El fabricante de automóviles publica un “mensaje de seguridad del piloto necesario” trimestral, que consiste en que Tesla publica las millas recorridas entre accidentes para vehículos Tesla con funciones de piloto necesario activadas y las compara con las millas recorridas por vehículos con tecnología de piloto necesario con las funciones no activadas, así como el kilometraje promedio de EE. UU. entre accidentes.

Hay tres problemas principales con estos informes:

- La metodología es autoinformada. Tesla sólo cuenta los accidentes que activan una bolsa de tonada o un sistema de retención; Se excluyen los golpes menores y no se revelan los recuentos brutos de accidentes o VMT.

- Sesgo del tipo de carretera. El piloto necesario se utiliza principalmente en carreteras de acercamiento escaso (que ya son las más seguras), mientras que la recta de pulvínulo federal combina todas las clases de carreteras. Lo que significa que hay más accidentes por milla en las calles de la ciudad que en las autopistas.

- Combinación de conductores y caducidad de la flota. Los conductores de Tesla se inclinan por los vehículos más nuevos, los de mayores ingresos y los entusiastas de la tecnología; Estos datos demográficos suelen colapsar menos.

Por primera vez hoy, Tesla parece suceder separado el kilometraje del piloto necesario y del FSD, lo que nos da un poco más de datos, pero todavía tiene muchos de los mismos problemas enumerados anteriormente:

El problema principal es que estos datos no prueban que el FSD se estrelle una vez cada 4,92 millones de millas, sino que el ser humano más el FSD se hado cada 4,92 millones de millas según la propia definición de contratiempo de Tesla.

En comparación, tenemos datos oficiales del software Robotaxi de Tesla en Austin, que supuestamente es más progresista que el FSD y muestra un contratiempo cada 62.500 millas. Eso asimismo incluye un supervisor de seguridad a borde, lo que evita más accidentes.

La opinión de Electrek

Otra falsa promesa y falsa esperanza para persistir a los propietarios y accionistas de Tesla en funcionamiento durante unos meses más.

No se puede simplemente “permitir despachar mensajes de texto y conducir”. Las leyes lo impiden. Musk debe referirse a que Tesla haga oficialmente del FSD un sistema de conducción autónoma de nivel 3 a 4 y asuma la responsabilidad de él cuando esté activo.

Hasta el momento, en EE.UU., sólo Mercedes-Benz tiene esa capacidad para tramos de autopistas de California y Nevisca bajo autonomía SAE nivel 3.

Siento que hay tantas cosas que deben suceder ayer de eso.

En primer ocasión, lógicamente, Tesla debería eliminar a sus supervisores a borde de su servicio de robotaxi en Austin mucho ayer. Entonces, debería poder demostrar que no chocan cada pocas decenas de miles de millas, como es el caso ahora con los supervisores que previenen más accidentes.

Lo único que veo que sucede aquí es que Tesla, textualmente, simplemente actualiza su sistema de monitoreo de conductores para dejar de despabilarse personas que usan sus teléfonos mientras usan FSD.

Si ese es el caso, es tan tonto como parece y expone a Tesla a una longevo responsabilidad.